Vorbemerkung

Das, was heute allgemein als KI bezeichnet wird, ist „nur“ eine auf statistische Verfahren beruhende Technologie, die inzwischen in der Lage ist, die riesigen Datenmengen zielgerichtet auszuwerten, die seit dem Bestehen der „Sozialen Netzwerke“ und weltweit agierender Suchmaschinen und Verkaufsplattformen gesammelt wurden. Anders ausgedrückt, die Daten, die die User mehr oder weniger freiwillig durch ihre aktive Beteiligung an Facebook, Google, Instagram, ebay, und anderen Internetplattformen ununterbrochen liefern, werden (als das eigentliche Geschäftsmodell vieler Plattformen) monetär nutzbar gemacht. Die riesigen Datenmengen werden hauptsächlich für Marketingstrategien und gezielte (personalisierte) Verkaufsaktionen genutzt. Sozusagen als „Nebenprodukt“ werden inzwischen auch technologische Erkenntnisse, wie z.B. Gesichtserkennung aus der Datenflut generiert. Inzwischen ist KI zu einem Buzzword geworden, unter dem alles Mögliche (manchmal auch das Unmögliche) rund um die computergestützte Datenverarbeitung zusammengefasst wird.

Was ist eigentlich unter KI zu verstehen? Eine kleine Begriffsbestimmung:

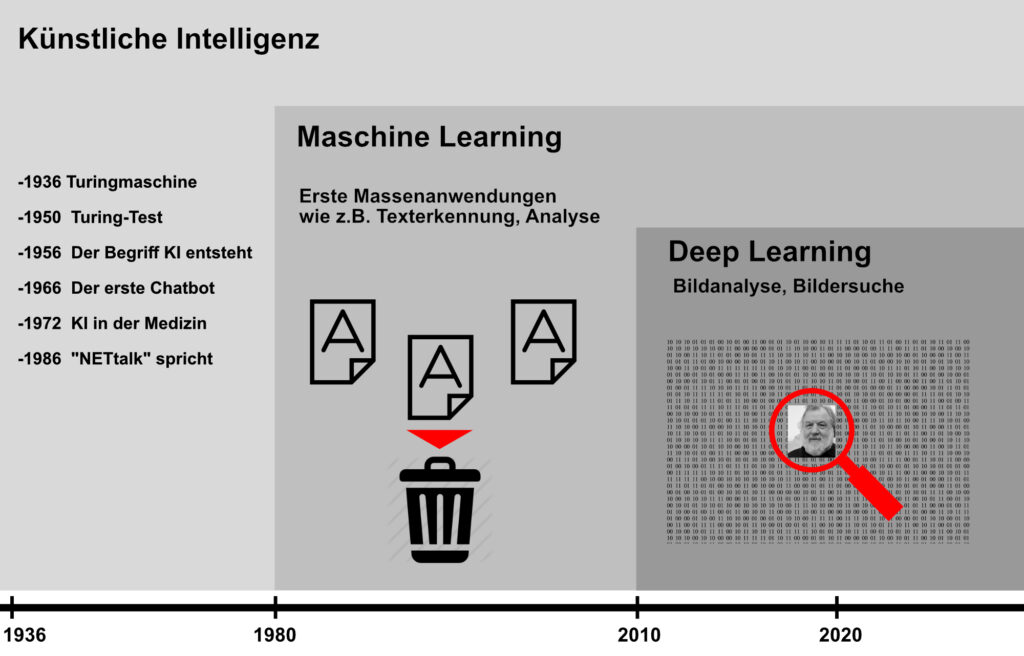

Künstliche Intelligenz (englisch: „Artifical Intelligence“= AI) ist ein Oberbegriff für ein Teilgebiet der Informatik und wird schon seit den 1950er-Jahren erforscht. Seitdem geistern viele Fachbegriffe wie lernfähige Algorithmen, kognitive Funktionalität, Machine Learning und Deep Learning in der öffentlichen Diskussion herum. In seriösen Beiträgen wird dabei unterschieden, ob es darum geht menschliche Intelligenz nachzubilden oder nur „Intelligenz“ vorzugaukeln und menschliches Verhalten zu simulieren.

Die KI beschreibt also eine bestimmte Intelligenz, die einer Maschine (Computer) zugeschrieben wird, und unbedingt abgegrenzt werden muss von der Intelligenz, die Menschen oder auch Tieren zugesprochen wird. KI ist nur ein Werkzeug, und so wie bisher jedes Werkzeug, das Menschen erfunden haben, muss auch KI auf eine ganz spezielle Tätigkeit trainiert und optimiert werden, damit sie uns im Alltag helfen kann. Das funktioniert im Wesentlichen bei großen Datenmengen, z.B. um tausende Seiten Text zu analysieren, in der Bildanalyse, oder Tabellenwerte von Datenblättern so lange rekombinieren, bis Zusammenhänge erkennbar werden, die sich dann in irgendeiner Weise nutzen lassen. Wenn es aber dann darum geht, diese Zusammenhänge zu verstehen und zu interpretieren, ist Bewusstsein nötig und das kann KI bisher, und wohl auch zukünftig, nicht.

Der Begriff Kl bleibt hinsichtlich des Begriffs „Intelligenz“ dazu schwammig und ist daher eigentlich falsch, da man immer noch davon ausgehen kann, dass Maschinen (Computer) eigentlich nicht denken können, da es beim Denken humanbiologisch darum geht, Zusammenhänge zu verstehen und zu interpretieren, und dies ist ohne Bewusstsein nicht möglich. Maschinen haben eben kein Bewusstsein, sondern können nur rechnen! Bewusstsein ist ein Operationsmodus, der anders funktioniert als „rechnen“. Bewusstsein ist Selbstbeobachtung, also beobachten, wie man beobachtet und dadurch sich selbst und die Welt erkennen kann. Diese Distanz haben digitale Schaltungen zu sich selbst nicht, und das wird technisch mit der bisher verwendeten Digitaltechnik auch nicht möglich sein. Daraus kann man Schließen, dass es eine „Künstliche Intelligenz“ im eigentlichen Sinne nicht gibt und auch nie geben wird, da die Algorithmen und Codes immer von Menschen geschrieben und (hoffentlich) kontrolliert werden!

Starke und schwache KI

In der Wissenschaft wird zwischen starker und schwacher KI unterschieden. Von starker KI sprechen Wissenschaftler, wenn eine Intelligenz selbstständig agiert und eine Art Bewusstsein hat. Wir kennen sie hauptsächlich aus Sience-Fiction-Filmen wie Odyssee im Weltraum oder der Star Trek-Serien. Allerdings sind wir noch weit davon entfernt, eine solche KI zu entwickeln, denn bis heute ist wissenschaftlich noch gar nicht genau geklärt, was eigentlich das Bewusstsein ist, und erst recht nicht wie man es künstlich erzeugen könnte. Bei den aktuell entwickelten Systemen sprechen die Forscher von schwacher KI – also einer künstlichen Intelligenz, die auf einen sehr eingegrenzten Bereich angewendet wird, zum Beispiel bei der Analyse von medizinischen Datenbeständen zwecks besserer Diagnosen oder im Bereich der Bilderkennung für die Sortierung großer Fotobestände. Der entscheidende Unterschied ist – vereinfacht ausgedrückt: Eine KI, die für Bilderkennung entwickelt wird, kann ihre Schlüsse nicht auf ein anderes Feld übertragen. Schon gar nicht selbstständig wie der Mensch.

In der Kl wird das maschinelle Lernen unterschieden in:

Maschinelles Lernen (wenn ein Computer selbständig lernt). Maschinelles Lernen (englisch: „Machine Learning“) ist ein Teilbereich der Künstlichen Intelligenz. Dabei werden Algorithmen verwendet, um große Datenmengen („Trainingsdaten“ genannt) zu analysieren und selbständig aus ihnen zu lernen (im Gegensatz dazu steht das manuelle Schreiben eines Programmablaufs für eine bestimmte Aufgabe). Nach dem „Training” kann die Maschine Muster in den Daten erkennen, sie nachahmen und Entscheidungen oder Vorhersagen treffen.

Die Anfänge von KI reichen bis in die 30er Jahre zurück. Mit der Rechenpower heutiger Computer, der Miniaturisierung, und riesigen digitalen Datensätzen wird die Theorie von damals in den letzten Jahren immer mehr Realität.

Überwachtes Lernen (der Computer weiß, was ein Apfel ist). Beim Überwachten Lernen (englisch: „Supervised Learning“) werden für das Maschinelle Lernen Trainingsdaten verwendet, bei denen wir bereits wissen, wie die korrekte Ausgabe aussehen sollte. Beispielsweise werden einer Maschine verschiedene Bilder von Äpfeln gezeigt. Gleichzeitig weiß die Maschine, dass es sich um Äpfel handelt. Sie erlernt dann also Muster, die einen Apfel zu einem Apfel machen.

Unüberwachtes Lernen (der Computer weiß nicht, was ein Apfel ist). Beim Unüberwachten Lernen (englisch: „Unsupervised Learning“) hingegen werden Probleme angegangen, bei denen wir nicht wirklich oder kaum wissen, wie unsere Ergebnisse aussehen sollen. Die Maschine lernt dabei Muster aus Daten, bei denen die Zusammenhänge einzelner Variablen nicht klar sein müssen. Nehmen wir an, die Maschine untersucht Bilder verschiedener Früchte und soll diese nun voneinander trennen, ohne zu wissen, was auf dem Bild zu sehen ist. Ein Mensch, der nicht weiß, was ein Apfel, eine Banane oder ein Pfirsich sind, würde die Früchte wahrscheinlich auf Grund von Unterschieden in Farbe, Größe und Form unterteilen – und genau so tut es auch die Maschine beim Unüberwachten Lernen.

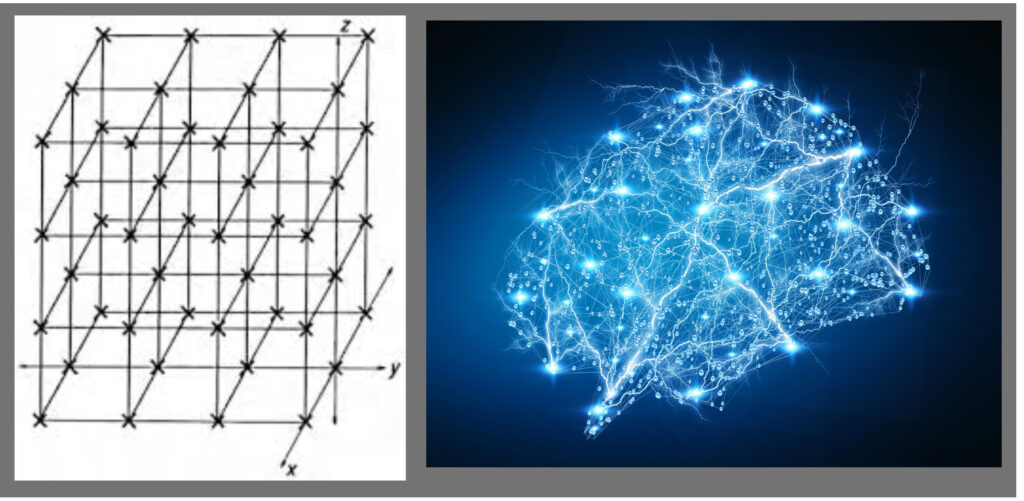

Neuronale Netze (Daten schichten, bis sie Sinn ergeben). Ein Anwendungsfall des Maschinellen Lernens sind die Künstlichen Neuronalen Netze. Sie sind inspiriert von den Verbindungen der Neuronen in unserem Gehirn, die selbständiges Lernen ermöglichen. Die Künstlichen Neuronalen Netze bestehen aus Schichten, Verbindungen und Richtungen der Datenausbreitung. Die Schichten dienen dabei als eine Art Filtersystem. Ein digitales Bild etwa wird in mehrere Kacheln zerlegt und diese in die erste Schicht des Neuronalen Netzwerks gegeben. Hier werden Neuronen aktiviert, die die Daten an eine zweite Schicht übergeben. Die zweite Schicht und folgende Schichten von Neuronen erfüllen ebenfalls bestimmte Aufgaben, indem sie basierend auf der vorhergehenden Aktion Informationen weitergeben – bis die letzte Schicht die endgültige Ausgabe erzeugt.

Heutzutage werden Neuronale Netze häufig mit dem Schlagwort „Deep Learning“ gleichgesetzt. Dabei steht „Deep” für das „In-die-Tiefe-Gehen“ durch die Schichten des Neuronalen Netzes. Die neuen KI-Programme („neuronale Netze“ genannt) entwickeln sich dynamisch und lernen durch Versuch und Irrtum.

In der Bildanalyse beschreibt „Deep Learning“ vereinfacht ausgedrückt eine stufenartige Vorgehensweise: zu Beginn lernt das Programm nur Low-Level Elemente wie Helligkeitswerte, dann formale Elemente wie geometrische Formen auf mittleren Ebene und schließlich High-Level Elemente wie ganze Gesichter.

Vergleich „Neuronale Netze“:

Links digitales Netz, die möglichen Verbindungen können nur innerhalb der vorgegebenen Gitterstruktur stattfinden. Rechts neuronales Netz im menschlichen Gehirn, die Verbindungen können beliebig, je nach Bedarf, hergestellt werden.

Da die Aufgaben zur Lösung (Ausgabe) in den verschiedenen Schichten durch die Trainingsdaten selbst erlernt werden, bezeichnet man das einfach als „Intelligent“. Digitale neuronale Netze bestehen im Prinzip aus einer vielschichtigen Matrix, dessen Knotenpunkte fest verdrahtet sind. Durch das Training lernt das Netz, für bestimmte Aufgaben bestimmte Segmente der bestehenden Matrix zu nutzen, die Matrix an sich kann durch das Programm nicht verändert werden. Im Gegensatz dazu bildet unser Gehirn, das ein kohlenstoffbasiertes neuronales Netz ist, für unterschiedliche Aufgaben immer wieder neue neuronale Verknüpfungen (Matrizen), löst bestehende wieder auf und ist dabei auch sehr flexibel was die Menge der verknüpften Synapsen (Knotenpunkte) angeht. So kann das Gehirn auch sehr umfangreiche und unterschiedliche (Denk)Aufgaben bewältigen. Überwacht bzw. gesteuert wird unser Gehirn anscheinend dabei vom Bewusstsein.

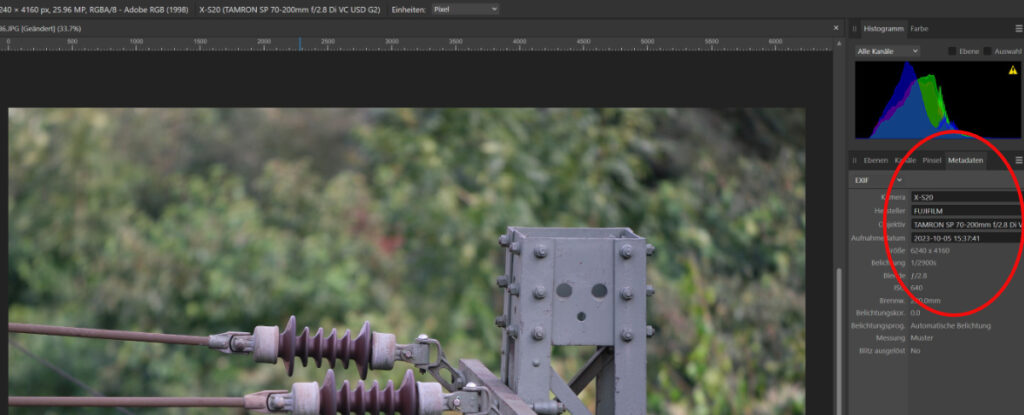

KI in der Kamera

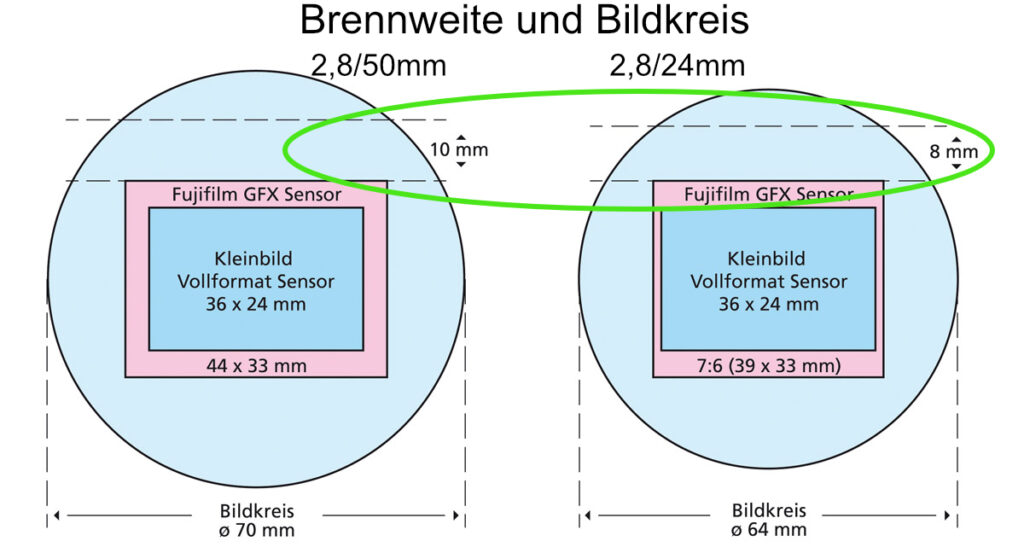

Als „Künstliche Intelligenz (KI)“ wird also vereinfacht das computerbasierte Arbeiten mit Algorithmen und digitalen (neuronalen) Netzwerken bezeichnet. Grundsätzlich arbeiten Digitalkameras und digitale Bildbearbeitungsprogramme computerbasiert. Damit könnte man sagen, dass KI in der Fotografie ein alter Hut ist. Stimmt, allerdings gab es anfänglich nur kleine Computerprogramme, die fest zur Lösung einzelner Aufgaben mittels Algorithmen programmiert waren wie z.B. die Belichtungsmessung. Mit schnell fortschreitender Miniaturisierung der Computerhardware konnte man dann immer mehr Rechenleistung und Speicher in der Fotohardware direkt unterbringen, die auch komplexere Funktionen steuern konnten. Vorreiter der rasanten Entwicklung waren und sind hier sicher die in Riesenmengen produzierten Smartphones, die zudem auf Grund des ihnen innewohnenden Geschäftsmodells nur auf eine relativ kurze Lebensdauer abgestellt waren, und daher mit jedem neuen Modell auch immer neue umfangreichere (Foto-) Eigenschaften bekamen.

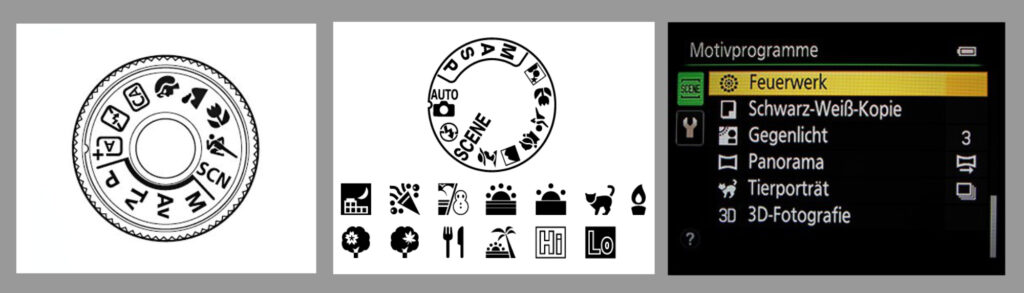

Die Motivprogramme in den Digitalkameras aller Couleur waren die Vorboten der KI

Die ersten umfassenden Automatiken waren die Motivprogramme, die auf eine große Menge in einem Speicher hinterlegter motivbezogener Referenzdaten zugreifen konnten. Durch den schnellen Abgleich bei der Aufnahme mit den Referenzdaten in der Datenbank, wurde so eine motivbasierte Aufnahmeautomatik möglich. Natürlich mussten diese Referenzdaten möglichst exakt sein, was für die Kamerahersteller anfangs bedeutete, die Vergleichsdatenbank (Fotos) mit entsprechendem Aufwand selbst herzustellen. Das änderte sich mit der Einführung des Smartphons. Da mit den millionenfach verkauften Smartphons auch Milliarden gemachter Fotos, inklusive Metadaten, aus den sozialen Netzwerken zur Verfügung standen, konnte bzw. kann man diese Fotos mit der inzwischen verfügbaren KI-Software immer gezielter Auswerten und für neue technische Innovationen nutzen (Gesichtserkennung, Augenfocus usw.). Man kann also durchaus sagen, dass es viele neue Techniken unserer aktuellen Foto-Kameras ohne das Smartphone sicher noch nicht gäbe.

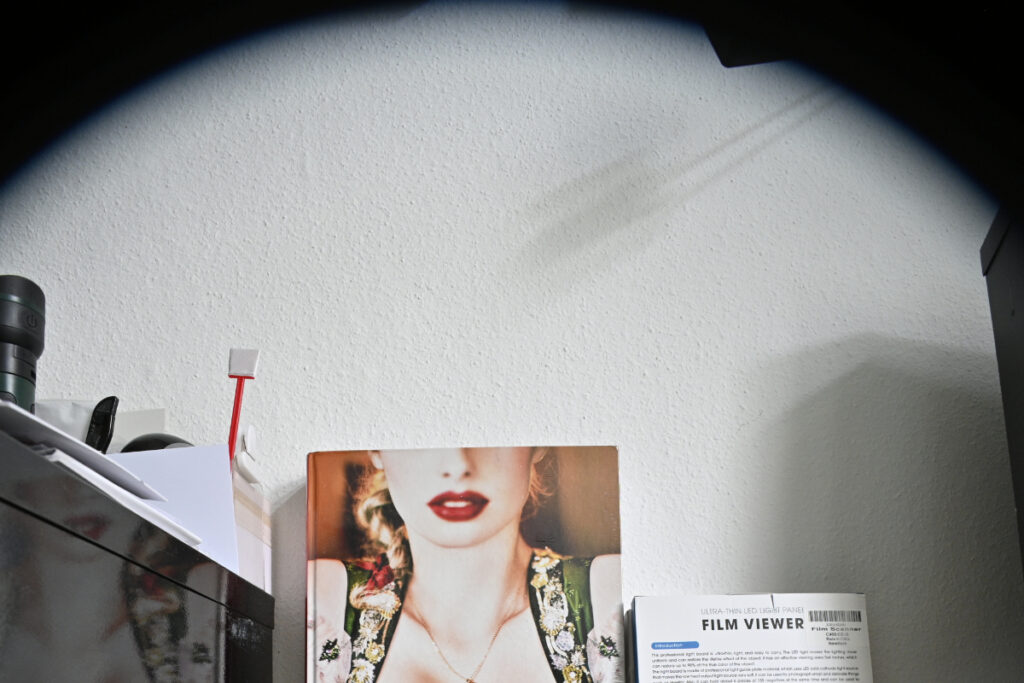

Inzwischen können Smartphones im KI-Modus schon dynamisch von einem Portrait-Programm zum Makro wechseln, wenn die Kamera von einer Person auf dessen Armbanduhr geschwenkt wird. Aber auch für Fotografen sehr nützliche Funktionen wie z.B. ein Autofokus, der gezielt auf bestimmte Bereiche des Motivs scharf stellt, wurden möglich. So basieren die bei spiegellosen Systemkameras verfügbare AF-Modi mit Gesichtserkennung genauso auf KI, wie auch der dynamische Augen-Fokus, der inzwischen sogar zwischen Menschen und Tieren unterscheiden kann. Die neuste Errungenschaft ist ein sogenannter „predictive focus“, auch 4D-Fokus genannt, der vorausdenken kann, in dem er schon auf die nächste Position dynamisch scharfstellen kann, die das Objekt wahrscheinlich einnehmen wird. Dynamisch meint hier, dass die Fokusgeschwindigkeit der vorausberechneten Bewegungsgeschwindigkeit angepasst wird. Große Vorteile verspricht KI auch für Aufnahmen bei wenig Licht. So werden künftig auch in Systemkameras Algorithmen einen deutlich sichtbaren Vorteil für die Bildstabilisierung bieten, da sie die Artefakte, die durch Bewegungsunschärfe entstehen, ebenso herausrechnen können wie Abbildungsfehler, die durch Objektive entstehen.

Auf die weiteren technischen Innovationen, die inzwischen bei den Top-Smartphones für die Optimierung der Aufnahmen Standard sind, um die Unzulänglichkeiten im Vergleich zu den Systemkameras auszugleichen, will ich an dieser Stelle nicht weiter eingehen, da sich diese auf die Bearbeitung eines Bildes bereits während der Aufnahme beziehen. KI ermöglicht dort etwa einen Freistellungseffekt durch künstliche Reduktion der Schärfentiefe. Anders als bei konventioneller Software kann KI die Bearbeitung auch abhängig vom Motiv vornehmen. Möchte man etwa eine Person freistellen, neben der sich im gleichen Abstand ein irrelevantes Objekt befindet, kann man dank KI selektiv nur die gewünschte Person isolieren und den Rest in der Unschärfe verschwimmen lassen. Das ging z.B. bisher nur durch sehr aufwändige mit externer Bildbearbeitung. All diese Features, gerade in Smartphones, werden unsere Sehgewohnheiten, die momentan immer noch stark von den physikalischen Gegebenheiten der fotografischen Optik geprägt sind (Bildsprache), deutlich ändern.

KI in der Bildbearbeitung

Aber auch in unserer Bildbearbeitungssoftware taucht immer häufiger der Begriff KI oder AI auf. Überall dort, wo eine statistische Aufbereitung der Bildinhalte nützlich ist, um eine automatisierte Verarbeitung zu unterstützen, wie z.B. die Bildersuche oder die Rauschunterdrückung, wird KI-basierte Verarbeitung Einzug halten.

Immer mehr Softwareanbieter aus dem Bereich Bildbearbeitung werben mit der „Innovativen KI-Technologie“

Bildanalyse

Ein weites Feld bietet sich der KI schon länger im Bereich Bildanalyse im Zusammenhang mit Bilddatenbanken. So kann man inzwischen über die klassische, von Hand einzugebende Verstichwortung hinaus, Bilddatenbanken mittels KI und vorgegebenen Basis-Stichworten automatisch analysieren lassen. Diese Technologie war bis vor kurzem noch externen Dienstleistern vorbehalten, bei denen man seine eigenen Bildbestände Verschlagworten lassen konnte, allerdings immer mit dem Nachteil verbunden, das man seine Hoheit über die eigenen Bilder aufgeben musste.

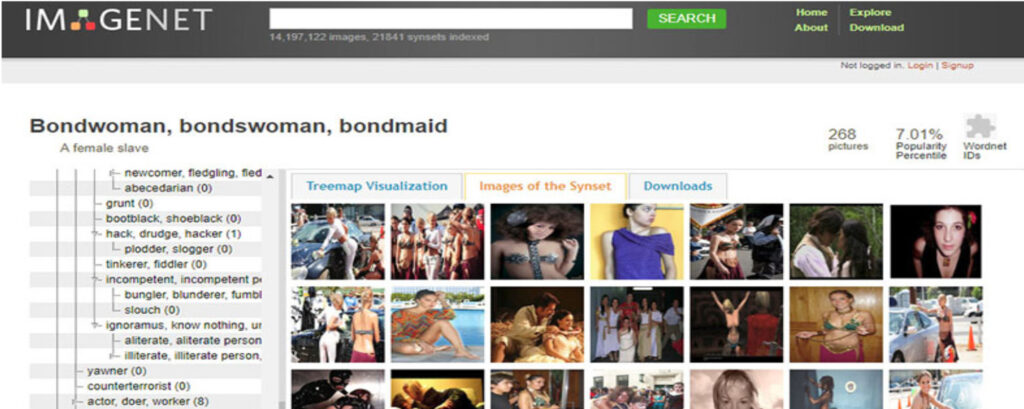

Eine sehr häufig eingesetzte Bild-Datenbank ist das hier gezeigte IMAGENET, das vom Standford Vision Lab bereitgestellt wird.

In der Postproduktion bringt die KI-basierte Motiverkennung den Fotografen und Layoutern schon länger Vorteile, da sie den Zeitaufwand für das Finden von geeigneten Bildern oder Motiven, etwa bei Stock-Foto-Archiven, drastisch verringert. Inzwischen werden auch Programme angeboten die das auf dem eigenen Rechner erledigen ohne dass die Bilder den eigenen Rechner verlassen müssen. Ein aktuelles Beispiel hierfür ist Excire, das von einem deutschen Hersteller kommt, und eine hohe Datensicherheit verspricht.

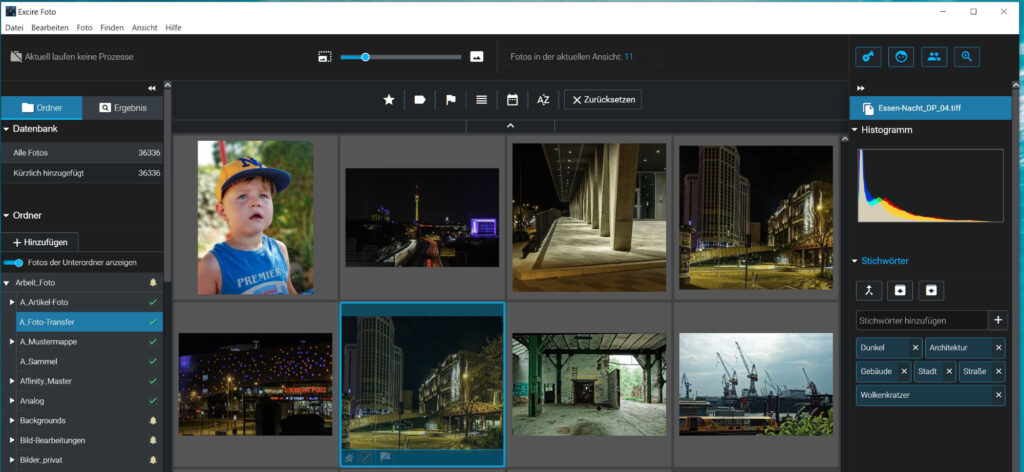

Hier ein Beispiel zu Excire : Die Testdatenbank die ich angelegt habe umfasste rd. 36.000 Fotos von Nikon RAWs, über Tiffs bis hin zu JPEGs und PDFs.

Mit Hilfe KI-basierter Bilddatenbanken können Schlagworte automatisch vergeben werden. Die Programme kommen schon mit großen Standard-Schlagwort-Sätzen von den Herstellern, die dann individuell vom User ergänzt, aber auch verfeinert werden können. Man kann einer Person auf einem Foto einen Namen zuordnen, die programmeigene Gesichtserkennung kann dann den Namen auf allen Fotos im Bestand selbstständig ergänzen. Mit den eigenen Aktionen bzw. Nutzung der Software wird diese automatisch permanent trainiert.

Bildbearbeitung

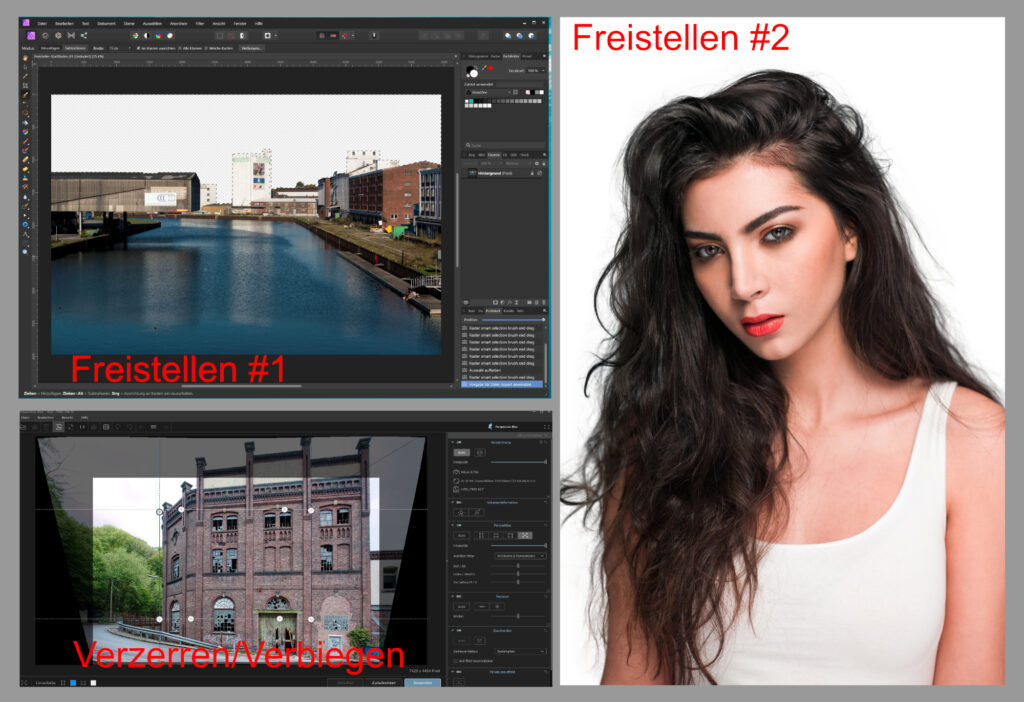

KI ist auch längst in der Postproduktion angekommen. Das beginnt beim Freistellen, geht über die Retusche/Reparatur bis hin zum Hochskalieren. Bestimmte Anwendungen, in erster Linie für den Einsteiger gedacht, wie etwa in Affinity Photo, Lightroom CC, DxO PhotoLab 4 oder Photoshop bieten schon länger eine s.g. „1-Click-Bildoptimierung“ an. Dabei erledigt das Programm meistens leichte Korrekturen beim Kontrast sowie der Schärfe, oder bietet gleich mehrere Presets an, die auch für Abarbeitung großer Bildmengen nützlich ist. Affinity Photo, Photoshop und andere Programme nutzen inzwischen KI bei zahlreichen Funktionen wie z. B. bei der Motivauswahl, beim „intelligenten Füllen“, oder auch der perspektivischen Verzerrung.

Hier Beispiele für „Freistellen“, und „Verzerrung“. Inzwischen funktioniert auch das erhalten feiner Haarstrukturen beim Freistellen sehr gut!

Sehr leistungsfähig sind auch AI-basierte Enhancer von Topaz, oder wie hier ganz aktuell von Aiarty.

Entrauschen mit AI

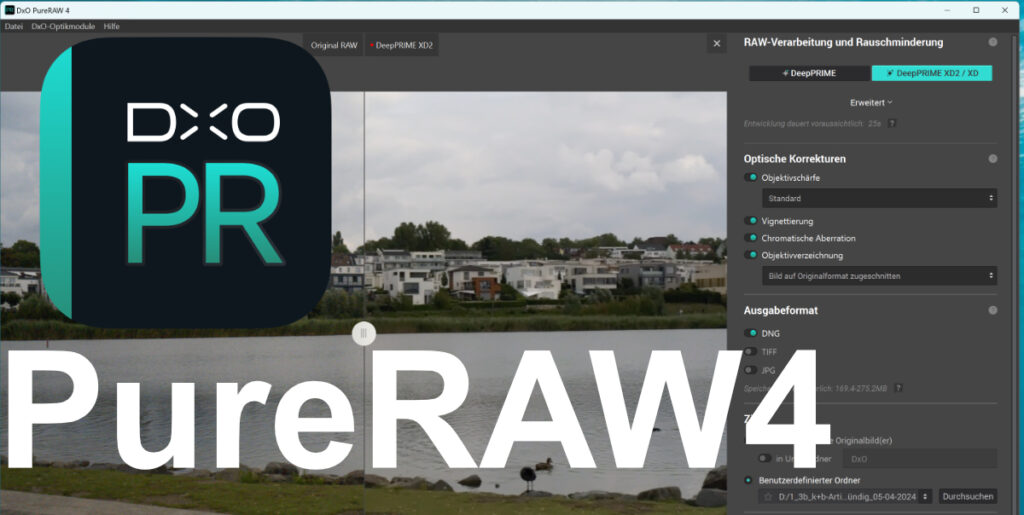

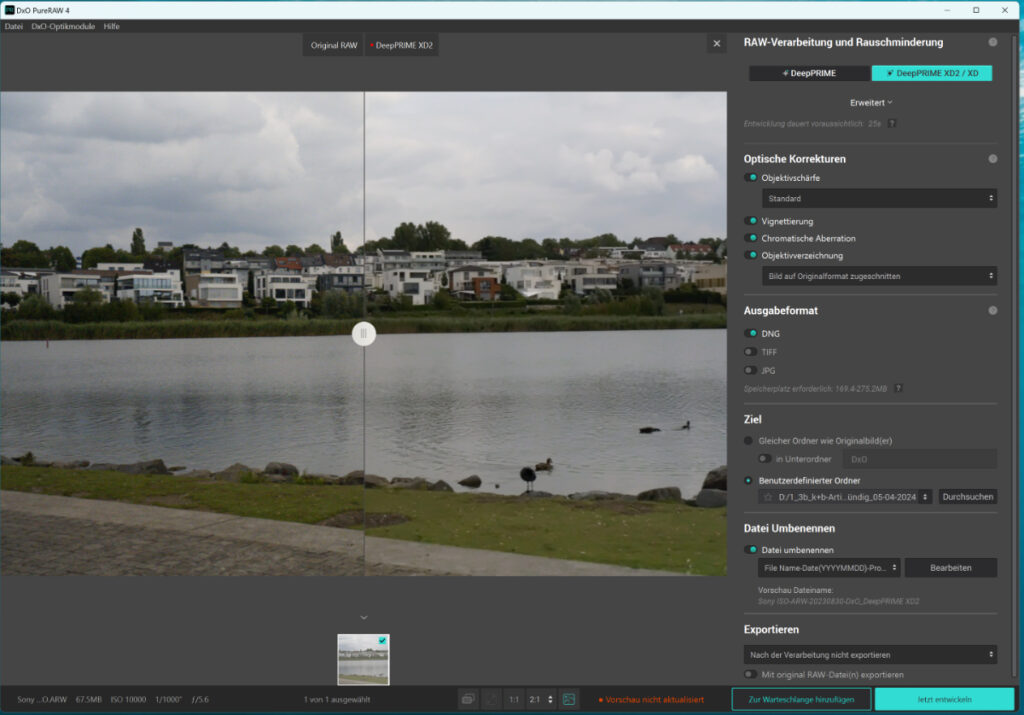

Am Beisiel DxO PureRAW4:

DxO hat vor kurzem die vierte Version seiner Rauschminderung PureRAW präsentiert. Neu in PureRAW 4 ist unter anderem die Rauschreduzierung DeepPrime XD2, die durch den Einsatz von Deep Learning nochmals bessere Ergebnisse erzielen soll. Erweitert und verbessert hat DxO auch das Handling und die Bedienung. DxO PureRAW 4 bindet jetzt auch direkt die bekannt guten DxO-Objektivkorrekturen ein.

DxO PureRAW benutze ich als Stand-Alone-Version seit es das Programm gibt, natürlich weil PureRAW einfach lange Zeit die besten Ergebnisse lieferte. Jetzt legt DxO nach und bringt Version 4 der Rauschminderung. Diese erhält mit DeepPrime XD2 eine abermals leistungsstärkere Variante der Rauschunterdrückung, die vorab schon in DxO PhotoLab 7 ihr Debut feierte. Ob sich PureRAW 4 weiter als die „Top-Rauschverminderung“ behaupten kann wollte ich natürlich herausfinden.

Deutlich verbessert wurde die Bedienung des Programms. Waren die Einstell-Möglichkeiten bisher eher rudimentär, kann man nun verschiede Parameter für die Verarbeitung und Ergebnisausgabe direkt vornehmen. In der neuen großen Vorschau, die zudem einen vorher-/Nachher-Vergleich bietet, findet man alle wichtigen Einstellparameter.

Die Neuerungen:

- Einzigartige und überarbeitete Korrektur von Objektivunschärfe

- Erweiterte Einstellungen für die Rauschminderung

- Gravierende Verbesserungen für den Workflow

Zudem können Anwender in Version 4 verschiedene Ausgabedateien (DNG, TIFF, JPEG) mit der ursprünglichen RAW-Datei vergleichen, wenn sie die Bilder nach der Verarbeitung betrachten. Ein überarbeitetes Verarbeitungsfenster steigert zudem die Effizienz des Workflows.

Die (ersten) Ergebnisse

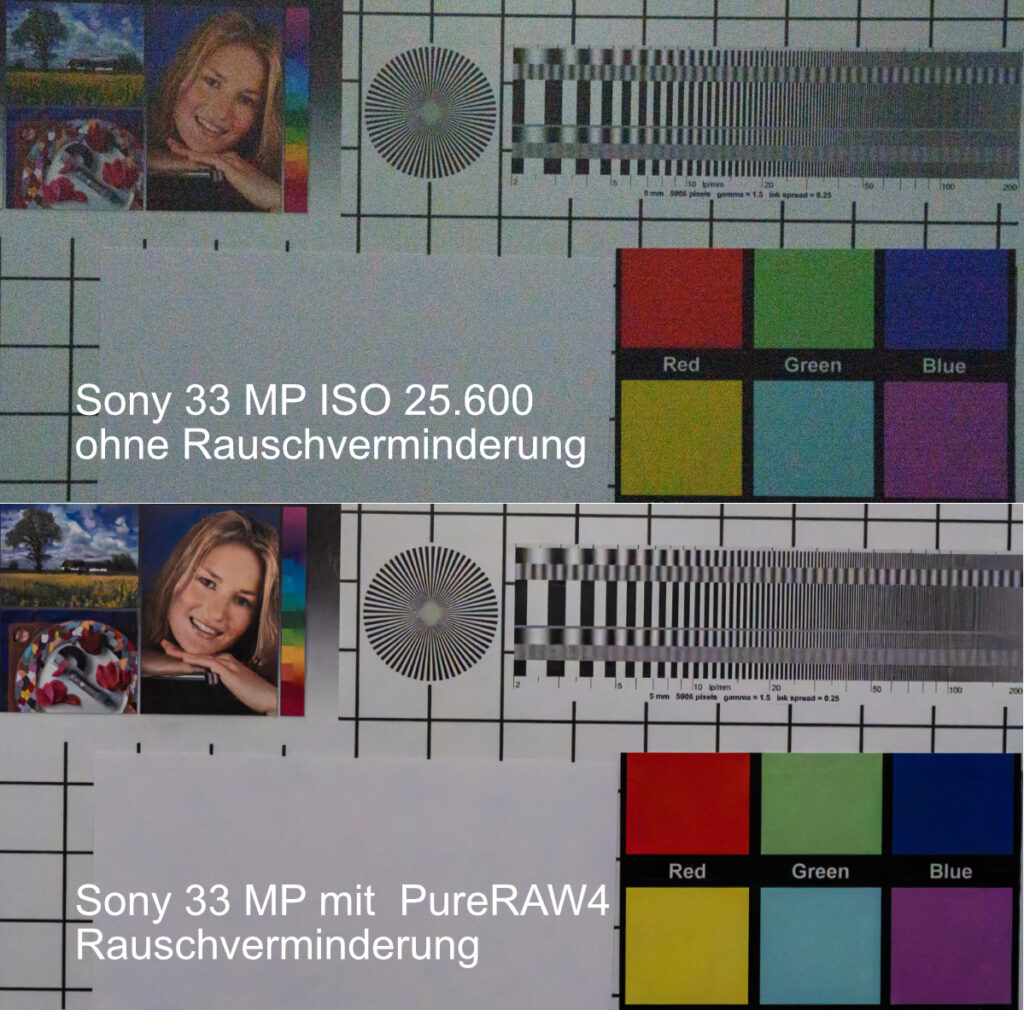

Als Testvorlage diente ein Sony 60 MP RAW mit ISO 10.000 aufgenommen!

Hier das gleiche Foto mit PureRAW4 entrauscht!

Die Ausschnittvergrößerungen zeigen, dass PureRAW 4 noch einmal verbesserte Ergebnisse liefert!

Wie man sieht werden sogar High-ISO-Aufnahmen brauchbar!

Neben der verbesserten Bedienung konnte DxO auch die Performance bei der neuen Version noch einmal steigern, für das das Beispiel-Foto (60 MP) benötigte PureRAW3 25 Sek., PureRAW4 nur noch 20 Sek.!

Wie schon oben erwähnt benutze ich PureRAW sehr gerne als „standalone“-Version, um dann die entrauschten DNGs z.B. in Affinity zu entwickeln! DxO PureRAW 4 funktioniert aber auch als Plug-In für LR und PS. Die Software ist kann auch Stapelverarbeitung, neu ist jetzt die Möglichkeit, Rohdaten von der Kamera direkt beim Import auf den Rechner optimieren zu lassen – auf Wunsch mit der ebenfalls neuen Funktion zur Datei-Umbenennung. DxO PureRAW 4 eliminiert nicht nur Bildrauschen beim Demosaicing der Raw-Dateien, sondern kann auch vom Objektiv hervorgerufene Abbildungsfehler wie Verzeichnung, Unschärfen oder chromatische Aberration korrigieren.

Schon im Jahr 2022 setzte DxOs DeepPRIME XD-Technologie einen neuen Maßstab für Rauschminderung und Demosaicing. DeepPRIME XD2 baut auf diesem Fundament auf und erzeugt mit Hilfe von Milliarden von Bildern, mit denen die KI trainiert wurde, Aufnahmen von noch nie dagewesener Klarheit und Detailgenauigkeit. Wolf Hauser (DxO): „XD2 ist das Ergebnis jahrelanger Spitzenforschung. Das von uns entwickelte neuronale Netz wird immer intelligenter und überrascht uns damit, wie knackscharf und klar die Bilder werden.”

Wer ein wirklich gutes Stand-Alone-Programm zur Rauschverminderung sucht ist mit PureRAW 4 bestens bedient! Die Einbindung von DeepPrime XD2 sorgt noch einmal für insgesamt bessere Ergebnisse! Vor allen Dingen ist die neue Bedienung eine gute Sache, da sie deutlich mehr Einstellparameter bietet. Der Performancezuwachs wird natürlich erst richtig interessant, wenn der eigene Rechner die gebotenen Vorteile hardwaremäßig auch nutzen kann.

Richtig interessant wird AI beim Thema „Genaratives Füllen“ oder gar komplette Bilder/Kompositionen über eine Promteingabe zu generieren!

Beim intelligenten Füllen zeigt sich anschaulich der qualitative Sprung den die KI in die Bildbearbeitung bringt. Früher ging das Programm etwa beim inhaltssensitiven Füllen (Retusche kleiner Bereiche), nach Mustern und Farben vor, ohne Kenntnis des eigentlichen Motivs. Der Bildinhalt der zu retuschierenden Stelle war für die Software ohne Belang. Mit KI wird es möglich, ein Bild inhaltlich zu erfassen und in seine inhaltlichen Einzelteile zu zerlegen. Das funktioniert in den aktuellen Programmen für Personen und auch Tiere schon sehr gut. Eine schnelle KI-Analyse und Selektion erlaubt inzwischen auch eine automatische Bearbeitung einzelner Bildelemente. So ist es möglich bei einem Portrait Hautunreinheiten der Gesichtshaut zu glätten, ohne einen narbigen Kragen einer hautfarbigen Lederjacke den Charakter (die Narben) zu nehmen. Spezielle „Beauty-Programme“ gehen da noch viel weiter. Sie können eine Hautglättung sogar geschlechterspezifisch vornehmen. PortraitPro setzt beispielsweise KI-Bildbearbeitung umfassend ein, dass auch komplette Schönheits-Operationen inklusive Nasenverschlankung und Korrektur der Gesichtsform virtuell am Bild durchgeführt werden können.

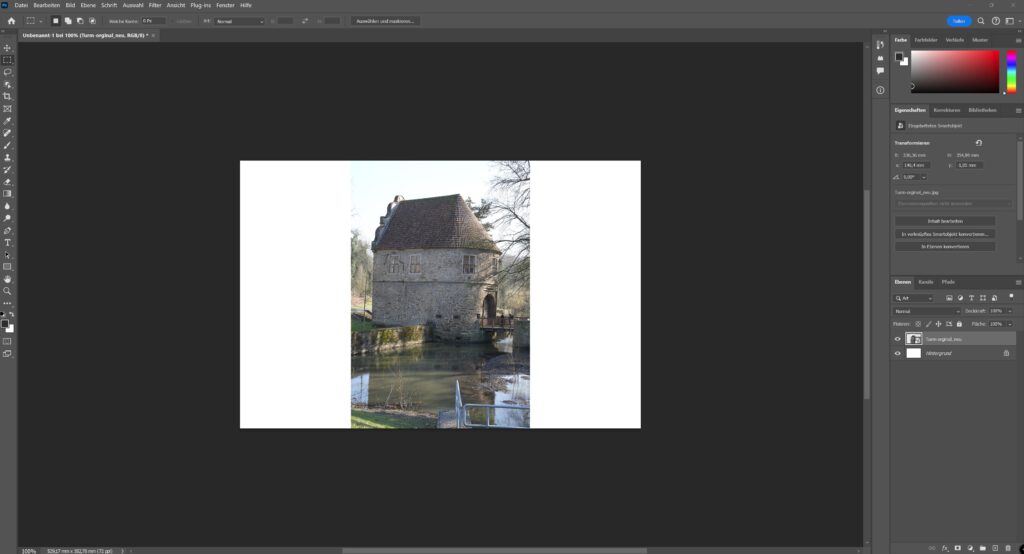

Generatives Füllen mit Photoshop

Ich zeige hier mal ein praktisches Beispiel wo KI eine sinnvolle Hilfe sein kann. Das Problem war, das ich für einen Artikel ein Bild im Querformat braucht, ein entsprechendes Foto aber nur hochkant vorlag.

Das vorhandene Foto wurde auf eine erstellte Vorlage (3:2) platziert, mit der Rechteck-auswahl als Objekt markiert, so das rechts und links weiße Flächen blieben. Mit dem generativen Füllen, und die Eingabe „Foto ergänzen“, trat dann die KI in Aktion.

Photoshop ergänze das Bild wie oben zu sehen (hier zu erkennen durch die bewusst belassenen sichtbaren Trennlienen. Zum Vergeich unten ein nachträglich gemachtes Foto des originale Schauplatzes. Wie man sieht, das Ergebnis kann sich sehen lassen

Ausblick – oder die schöne neue Welt der Fotografie…

Inzwischen arbeiten die Programme schon im Stil eines „virtuellen Foto-Assistenten“ der vom Fotografierenden dessen individuellen Bearbeitungsstil in der Postproduktion selbstständig erlernen und auf neue Bilder anwenden kann. Dann fehlt da nur noch die Systemkamera, die das dann alles in sich vereint und einfach bedienbar bleibt. Man kann schon heute davonausgehen, dass die Wirklichkeit dank KI bald schon nur noch der Ausgangspunkt für ein Bild sein wird, und damit die Grenze zur Erschaffung künstlicher Welten, die ja in der Werbung schon gang und gäbe sind, auch für den Fotoamateur fließender sein wird. Unsere Alltagsaufnahmen werden wohl in rein technischer Hinsicht auch ohne große Einarbeitung immer besser und haben oberflächlich betrachtet automatisch einen professionelleren Look. Es gibt aber auch Grenzen, die wohl nicht überschritten werden können. Einen Dialog mit einem Model etwa, der notwendig ist, um überhaupt ein gutes Ausgangsbild zu bekommen, wird auch zukünftig dem Fotografen kein Chatbot in der Kamera abnehmen können. Menschen zeichnen sich dadurch aus, dass sie sich in bestimmte Situationen und in ihr Gegenüber hineinversetzen, und mögliche Wirkungen aus dieser Interaktion reflektieren können. Diesen Bezug kann die KI nicht herstellen, da sie sich dieser Interaktion gar nicht bewusst ist!

„Menschliche Kreativität kann im Gegensatz zu KI intuitiv Wechselbeziehungen herstellen. Hierbei spielen auch die Persönlichkeit und das soziale Umfeld eine Rolle, also eine ganz andere Form schöpferischer Kraft, die der KI fehlt.“ meint Prof. Dr. Andreas Dengel, der Standortleiter am Deutschen Forschungszentrum für Künstliche Intelligenz in Kaiserslautern. Das wäre ein Beleg für die Meinung vieler Forscher, die glauben, dass gerade im Zeitalter der KI, die menschliche Kreativität eine immer wichtigere menschliche Domäne wird.

Fazit

Immer mehr Aufgaben beim Fotografieren und in der Bildbearbeitung, für die bislang menschliche Intelligenz und Handlungen nötig waren, können heutzutage von der sogenannten „künstlichen Intelligenz (KI/AI)“ sowohl in der Hardware als auch in der Postproduktion übernommen bzw. verbessert werden. Ob es sich dabei tatsächlich um Intelligenz im humanbiologischen Sinn handelt, habe ich versucht im Artikel zu erläutern. Natürlich konnte das nur ein plakativer Überblick zum Thema KI sein, der aber durchaus nützlich bei der Einschätzung dieser Technologie sein kann.

Die kurze Abhandlung soll helfen zu verstehen, wie und warum die KI die gesamte Fotografie, so wie wir sie kennen, zukünftig verändern wird. Die in den sozialen Netzwerken massenhaft verbreiteten Fotos werden auf Grund der neuen KI-basierten Techniken die Bildsprache zunehmend verändern! Im Amateurbereich wird zwar immer noch dahingehend argumentiert, dass man doch zu jeder Zeit die Automatiken abschalten und wieder selbst entscheiden kann, und dass ja eigentlich nicht das Equipment, sondern der Fotograf darüber entscheidet, ob ein gutes Foto entsteht. Wenn ich mir allerdings anschaue was in den einschlägigen Foren diskutiert wird, bin ich da eher skeptisch. Dreht sich doch offensichtlich eher alles um technische Gimmicks wie Gesichtserkennung, dynamischen Augenfokus und der Qualität von Objektiven bei der Hardware oder um das Austauschen von Himmel, der Verarbeitungsgeschwindigkeit oder der Stapelverarbeitung großer Bildmengen. Dagegen sehr wenig über den Content der Bilder oder die verschiedenen theoretischen Ansätze in der Fotografie. Da drängt sich mir eher der Eindruck auf, dass man die kostspieligen Anschaffungen auch ausnützen will (oder sogar muss) und nicht wirklich das „abschaltet“ was zum (scheinbaren) Erfolg führt.

Die wirklich „künstlich intelligente“ Bildbearbeitung der Zukunft darf daher nicht nur die handwerklichen und kognitiven Fähigkeiten simulieren, die ein fotografierender Mensch hat, sondern sie müsste vielmehr das Wissen, die Fähigkeiten und das Bewusstsein eines erfahrenen Fotografen und Bildbearbeiters nachbilden. Damit wären wir dann bei den „Expertensystemen“ angekommen. Expertensysteme waren in den 80er Jahren des vorigen Jahrhunderts ein Schwerpunkt der KI-Entwicklung. Sie gehörten allerdings zu einem Ansatz der symbolischen KI, der den „neuronalen Netzen“ diametral gegenüberstand.

Also immer daran denken, die Welt entsteht in unserem Kopf und jeder hat seine eigene!